„Nachvollziehbare Forschungsdaten schaffen Vertrauen in die Wissenschaft“

- Top-Meldungen

- Forschung

- Reihen & Dossiers

Herr JProf. Hermann, warum liegt Ihnen das Thema Open Science am Herzen?

Ich finde Open Science – also eine Offenlegung des Forschungsprozesses – aus mehreren Gründen sehr wichtig: Im Sinne der „accountability“ (dt.: Rechenschaft) geht es mir insbesondere darum, dass wir zu unseren wissenschaftlichen Ergebnissen stehen und anderen die Möglichkeit einräumen, diese Ergebnisse zu überprüfen. In der Informatik war es lange Zeit möglich, Ergebnisse nur anhand der Veröffentlichungen nachzuvollziehen, also ohne dass man dafür die dahinterliegenden Forschungsartefakte kennen musste. Das wird aber zunehmend schwieriger, da diese Forschungsartefakte immer komplexer werden. Meiner Meinung nach ist es daher wichtig, Open Science zu verfolgen und zu fördern, weil der bislang nur auf Publikationen basierende Peer Review-Prozess sonst irgendwann an seine Grenzen kommt. Und das System Peer Review, also die gegenseitige Überprüfung von wissenschaftlichen Erkenntnissen, ist essenziell in der Wissenschaft. Auf Webseiten wie „Retraction Watch“, die über zurückgezogene Artikel informieren, sehen wir, dass deren Zahl schon zugenommen hat. Dahinter muss übrigens längst nicht immer bewusste Fälschung stecken, es können im wissenschaftlichen Prozess auch Dinge übersehen und Fehler gemacht werden. Solche Fehler erkennt man nicht unbedingt immer beim Peer Review der Publikation selbst, denn dort lässt sich häufig nicht der Prozess in allen Details nachvollziehen. Deswegen ist es so wichtig, als Wissenschaftler*in offen zu sein und die Publikation nicht als einziges Mittel der Kommunikation zu wählen, sondern auch alle anderen Quellen, die man erstellt hat, bereitzustellen (z.B. Forschungsdaten, Codes, Prototypen, etc.). Wenn wir Forschungsdaten nicht nachvollziehbar machen, kann man das Vertrauen, das in die Wissenschaft gesetzt wird, aus meiner Sicht nicht mehr rechtfertigen. Deshalb ist mir das Thema Open Science so wichtig.

Inwiefern profitieren Wissenschaftler*innen davon, wenn Forschungsdaten geteilt werden?

Öffentlich zugängliche Forschungsartefakte bieten die Chance, mit der eigenen Forschung auf bestehenden Forschungsdaten, -prototypen und Ansätzen aufbauen zu können. So können wir schneller zu neuen Erkenntnissen gelangen. Wenn diese Erkenntnisse bzw. der Prozess auch noch extern geprüft werden, haben wir eine starke Basis, auf die wir wissenschaftlich weiter aufbauen. In der empirischen Sozialforschung werden beispielsweise auch ganze Interview-Methodiken und Fragebögen geteilt. Das sind interessante Artefakte, also Informationen, auf die man dann wiederum seine eigene Forschung stützen kann.

Viele Ihrer Kolleg*innen sehen das Teilen von Forschungsdaten und Methoden dennoch skeptisch, weil es sehr aufwendig ist. Wie sehen Sie das?

Die Kolleg*innen haben durchaus recht. Es gibt zwar inzwischen Möglichkeiten, die eigenen Daten bereitzustellen, aber das ist vielfach noch recht kompliziert und es ist vor allem schwierig, die Daten so aufzubereiten, dass sie für alle verfügbar und verständlich sind. Die große Herausforderung besteht also darin, Methoden zu entwickeln, um Software, Datensätze und Datenanalysen nachvollziehbar zu dokumentieren und nachnutzbar zu machen – und das über verschiedene Infrastrukturen hinweg. Hier haben wir in den vergangenen Jahren große Fortschritte gemacht und ich bin sehr zuversichtlich, dass wir auf kurz oder lang Methoden finden, um die Bereitstellung von Forschungsdaten einfacher zu gestalten. Entscheidend ist dann aber auch eine Bereitschaft der Forscher*innen, die eigenen Datensätze – und nicht nur die finale Publikation – zu veröffentlichen. In vielen Fällen ist die Hürde auch gar nicht so groß, wie man denkt. Häufig reicht die reine Bereitstellung eines Datensatzes schon aus. Man muss ihn nicht in allen Feinheiten dokumentieren und aufbereiten. Viele Wissenschaftler*innen weltweit sind dankbar, wenn sie überhaupt irgendetwas vorfinden, auf das sie zurückgreifen können, und nehmen sich auch die Zeit, um die Daten zu verstehen.

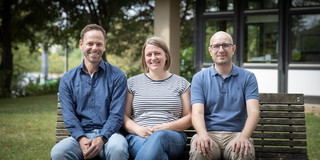

Zur Person:

- seit 2020 Juniorprofessor an der TU Dortmund und Leiter der „Secure Software Engineering Group“

- 2019–2020 Vertretungsprofessur für IT-Sicherheit an der Universität Paderborn

JProf. Hermann wird als Data Champion porträtiert, weil er sich auf wissenschaftlicher sowie konzeptioneller Ebene für nachvollziehbare Daten und Open Science einsetzt.

Text: Forschungsdatenservice

Weitere Informationen: