Blick in die Blackbox

- Künstliche Intelligenz

- mundo

Es ist eine der erstaunlichsten Leistungen des Homo Sapiens: Der Mensch hat die Funktionsweise seines eigenen Gehirns nachgebaut. Künstliche neuronale Netze lernen selbstständig – und übertreffen dabei die Fähigkeiten ihrer Entwickler*innen regelmäßig. Wie die Künstliche Intelligenz (KI) genau vorgeht und welche Ergebnisse sie produziert, können wir kaum mehr nachvollziehen. Das sollten wir aber, findet Prof. Daniel Neider. Gemeinsam mit einem auf zwei Kontinente verteilten Team arbeitet er daran, KI vertrauenswürdig zu machen.

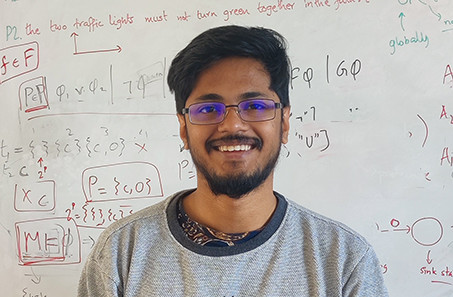

Dortmund, Kaiserslautern, Austin (Texas) und Tempe (Arizona): In diesen Städten arbeiten die Mitglieder der international und interdisziplinär zusammengesetzten Gruppe um Prof. Daniel Neider und seinen Doktoranden Rajarshi Roy. Sie haben sich auf die Fahne geschrieben, Künstliche Intelligenz besser verstehbar und sie dadurch auch vertrauenswürdiger zu machen. Die fünf Forscher und eine Forscherin in diesen Städten kommen aus den USA und Deutschland, aber auch aus Indien und Frankreich. Wie kommt es zu dieser Zusammenarbeit über Tausende Kilometer?

Daniel Neider, theoretischer Informatiker und seit Ende 2022 Professor für Verifikation und formale Garantien des Maschinellen Lernens am neu gegründeten „Research Center Trustworthy Data Science and Security“ der Universitätsallianz Ruhr, forschte zuvor in Kaiserslautern und noch früher als Postdoc in den USA. Dort lernte er Kollegen kennen, zu denen er die Verbindung hielt. „Inzwischen ist daraus eine langfristige Kooperation erwachsen mit mehreren Arbeiten, die aufeinander aufbauen. Wir ergänzen uns einfach und passen gut zusammen: Wir in Deutschland machen die theoretische Arbeit, die amerikanischen Kollegen die experimentelle“, sagt Neider.

Vertrauen durch Verständnis

Viele Entscheidungen, die Künstliche Intelligenz trifft, sind für den Menschen rätselhaft, unverständlich – und manchmal gar hoch umstritten. Dort, wo wir uns bereits auf die vermeintliche Unbestechlichkeit und Objektivität Künstlicher Intelligenz verlassen, stellen wir fest, dass sie so objektiv gar nicht ist – eben weil die Daten, die die Grundlage ihrer Entscheidungen sind, häufig von Menschen stammen. So spiegeln sich rassistische Vorurteile wider, wenn Algorithmen in den USA Afroamerikaner*innen bei der Beurteilung ihrer Kreditwürdigkeit benachteiligten. Dass KI teils verheerende Fehler macht, erfuhr die Weltöffentlichkeit auch 2015 und 2018, als (teilweise) autonom fahrende Fahrzeuge in den USA tödliche Unfälle verursachten.

In Deutschland sind vollständig selbstfahrende Autos noch nicht zugelassen – weil sie noch nicht hundertprozentig sicher sind, und weil wir ihnen noch nicht vertrauen. „Es ist schwierig, einem System zu vertrauen, wenn man nicht genau weiß, wie es funktioniert. Das ist unsere Arbeitshypothese“, sagt Neider. Seine Mission lautet: Vertrauen durch Verständnis.

Nun haben der durchschnittliche Fluggast oder die typische Pkw-Besitzerin auch wenig Ahnung, warum genau ein Flugzeug in der Luft bleibt und wie das eigene Auto funktioniert. Immerhin wissen das aber diejenigen, die Fahr- oder Flugzeuge bauen. Sie haben sie entwickelt und die Systeme darin programmiert; von ihrer Eingabe ins System hängt die Ausgabe ab. Gibt es einen Fehler im System, so lässt sich dieser in der Regel finden und das System umprogrammieren. „Bei der KI ist das anders. Anstatt dass Ingenieur*innen die Software programmieren, lassen sie einen Algorithmus über eine Masse Daten laufen und suchen nach Mustern. Das Problem: Irgendwann weiß niemand mehr, was intern genau passiert. Der Algorithmus hat ein Muster erkannt, aber der Rest ist eine Blackbox“, schildert Neider. „Es ist für den Menschen in der Regel unmöglich, das Verhalten einer KI durch einfache Beobachtung vorherzusagen“, ergänzt Rajarshi Roy. „Unser Ziel ist es daher, für Menschen interpretierbare Modelle zu generieren.“ Anders gesagt: Das Team versucht, Licht in die Blackbox zu bringen.

Das ist zum einen nötig, um Vertrauen herzustellen. Zum anderen verlangen gesetzliche Vorgaben eine gewisse Transparenz der KI, zum Beispiel der Artificial Intelligence Act der Europäischen Union: Es muss künftig dargelegt werden können, warum jemand keinen Kredit bekommt – ein Verweis auf die höhere Vernunft datenbasierter Künstlicher Intelligenz reicht da nicht aus. „Unsere Forschung zielt dabei nicht auf den Endkunden ab, sondern zunächst einmal auf diejenigen, die mit KI arbeiten müssen: die Techniker*innen“, sagt Daniel Neider. „Wir wollen die Funktionsweise einer Künstlichen Intelligenz in ihrer Sprache beschreiben, mit den Methoden, die sie schon kennen und die sie bereits erfolgreich anwenden, um klassische Hard- und Software sicher zu machen.“

„Es ist für Menschen unmöglich, das Verhalten einer KI durch einfache Beobachtung vorherzusagen.“ Rajarshi Roy

Das Verhalten Künstlicher Intelligenz in eine mathematische Sprache, eine Programmiersprache rückübersetzen, so dass Ingenieur*innen sie verstehen – das ist grob das Ziel. Es hilft dem Verständnis, wenn man dabei an einen Aufzug denkt: ein Beispiel, das Neider auch bei seinen Studierenden häufig verwendet. Einen Aufzug kann man so programmieren, dass er immer wieder ins Erdgeschoss fährt, nachdem er seinen Auftrag beendet hat. Aber ist das auch das Optimale, um Fahrt- und Wartezeiten möglichst gering zu halten oder um Strom zu sparen? Eine KI könnte das herausfinden, indem sie Daten sammelt, z.B. Warte- und Fahrtzeiten. Außerdem könnten die Nutzer*innen des Aufzugs jede Fahrt bewerten. Je mehr Daten die KI bekommt, desto besser. „Am Ende funktioniert der Aufzug auf Grundlage der vorliegenden Daten vermutlich optimal – aber wir haben keine Ahnung, wie genau“, sagt Neider. „Also beobachten wir, was die neue Steuerung tut, und beschreiben es in der Sprache der Ingenieur*innen.“

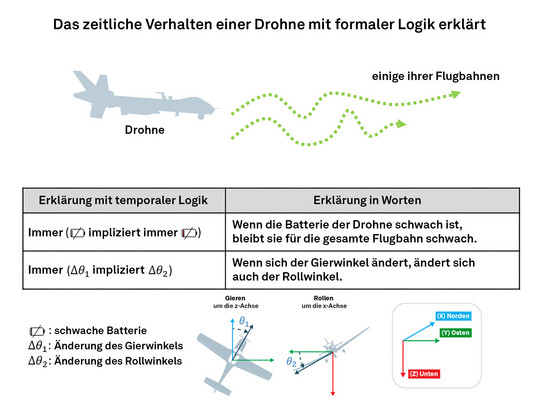

Ein Beipackzettel zur KI

Vielleicht möchten die Aufzug-Hersteller das von der KI als optimal errechnete Verhalten des Aufzugs trotzdem verändern – etwa, weil es spezielle Brandschutz-Vorgaben gibt, die die KI nicht berücksichtigt. Dann müssten die Entwickler*innen dafür sorgen, dass das System neue Dinge aus anderen Daten lernt. Die Möglichkeit einer solchen Analyse gibt es aber nur, wenn ein Verständnis für das Funktionieren des Systems da ist. „Reverse Engineering“ nennt Daniel Neider das: „Wir zerlegen die Komplexität wieder in einzelne Schritte und legen den Ingenieur*innen quasi einen Beipackzettel zur KI dazu.“ Der enthält zwar keine Risiken und Nebenwirkungen, dafür aber Formeln mit zeitlichen Operatoren und Wenn-Dann-Szenarien, die beschreiben, was ein System nie und was es immer tut, was es im nächsten Schritt tut, wenn x geschieht, und was, wenn künftig y gilt. „Wir schauen dabei nicht ausschließlich auf das Verhalten im Moment, sondern auf das Verhalten über die Zeit“, sagt Doktorand Roy, und Neider ergänzt: „Der temporale Aspekt ist unsere Nische. Die Übertragung der klassischen Methoden der Informatik auf die KI ist einer der Trends, die meine Gruppe erfolgreich mit vorantreibt. Langsam wird verstanden, dass Forscher*innen aus der klassischen Informatik, die in der Softwaresicherheit arbeiten, wertvolle Beiträge leisten können, um KI sicher und verständlich zu machen.“

Ein Prototyp ist bereits entwickelt, der für Expert*innen verständliche Beschreibungen des Verhaltens Künstlicher Intelligenz überzeugend generieren konnte – zumindest im Forschungssetting. „Es ist Grundlagenforschung“, sagt Daniel Neider, „und wir haben uns erst einmal kleine, nicht allzu komplizierte Systeme wie eine autonom fliegenden Drohne herausgesucht, um sie zu verstehen bzw. zu beschreiben. Der nächste Schritt ist nun, das im Anwendungsbereich auszuprobieren, zum Beispiel gemeinsam mit Ingenieur*innen.“

Cristiano Ronaldo und die KI

Die Forschung an der Vertrauenswürdigkeit ist in der KI ein noch junges Thema, das aber zunehmend wichtig wird – weil KI in immer mehr Gebieten zum Einsatz kommt. Dafür rücken zwei traditionell getrennte, sich beinah widersprechende Ansätze wieder zusammen: der induktive und der deduktive. Die klassische, deduktive Methode besteht darin, mit logischen Formeln und auf der Basis von Axiomen, also als unumstößlich geltenden Voraussetzungen, neue Fakten abzuleiten. Die induktive Methode sieht vor, aus Daten zu verallgemeinern, so wie es neuronale Netze tun. „Inzwischen erkennen wir jedoch, welchen Mehrwert eine Kombination der beiden Methoden haben kann“, sagt Daniel Neider. Der Ansatz seines Teams besteht darin, das Beste aus den Ansätzen beider Welten zu nutzen: „Es geht darum, eine Regel zu verbinden mit den Daten, die man hat.“

Daniel Neider nennt ein anschauliches Beispiel: „Die KI soll anhand der Bilder einer Fußballübertragung herausfinden, welche Spieler auf dem Spielfeld sind. Für uns Menschen wäre es offensichtlich, dass zum Beispiel Cristiano Ronaldo nicht zweimal auf dem Spielfeld sein kann – das ist ein Axiom. Ein neuronales Netz muss das erst einmal sehr aufwändig herausfinden.“ Klar: Das System „sieht“ nie, dass Ronaldo zwei- oder mehrmals im Bild ist, und es erkennt, dass er entweder einmal oder keinmal drauf ist. So kommt es irgendwann zu dem Schluss: Ronaldo gibt es nur einmal. Informationen wie diese, physikalische Gesetze zum Beispiel, könnte man der KI mit ins System geben. Neider: „Das ist eine sehr spannende Entwicklung, sie macht die Prozesse dateneffizienter, schneller – und wohl auch weniger fehleranfällig.“

Text: Katrin Pinetzki

Zu den Personen:

Prof. Dr. Daniel Neider hat seit Ende 2022 die Professur „Verifikation und formale Garantien des Maschinellen Lernens“ inne. Die Professur ist die erste, die am neuen „Research Center Trustworthy Data Science and Security“ der Universitätsallianz Ruhr besetzt wurde, und ist an der Fakultät für Informatik der TU Dortmund verortet. Daniel Neider studierte Informatik und Wirtschaftsinformatik an der RWTH Aachen, wo er auch promovierte. Anschließend forschte er zwei Jahre lang als Postdoc an der University of Illinois at Urbana-Champaign (USA) und der University of California, Los Angeles (USA). Fünf Jahre lang arbeitete er am Max-Planck-Institut für Softwaresysteme in Kaiserslautern, bis er 2022 seine Habilitation in theoretischer Informatik an der TU Kaiserslautern einreichte. Nach einem Jahr als Professor für Sicherheit und Erklärbarkeit lernender Systeme an der Carl von Ossietzky Universität Oldenburg nahm er den Ruf an die TU Dortmund an.

Rajarshi Roy ist Doktorand am Max-Planck-Institut für Softwaresysteme in Kaiserslautern. Seine Promotion im Fach Informatik wird von Prof. Daniel Neider betreut. Er studierte Mathematik und Informatik in Chennai (Indien).

Dies ist ein Beitrag aus der mundo, dem Forschungsmagazin der TU Dortmund.